获得对整个阿里云部署的网络可视性

在许多企业中,IT 团队仍在依赖 SNMP 和流日志等传统监控工具。但在公共云监控方面,这些传统工具存在较多盲点。由于它们无法越过企业边界,所以在多云和混合环境下无法深入洞察基于云的应用交付和服务间通信。在阿里云部署中,这种运营盲点可能会影响您的投资效益,导致企业的数字体验不尽如人意。

是时候做出改变了!现在,您可以摆脱云平台部署带来的复杂运营挑战,打造卓越的数字体验。借助 ThousandEyes 阿里云监控解决方案,您将能够全面衡量并直观呈现每条服务交付路径中的应用性能和网络层性能,无论是云到云、互联网到云还是区域间的服务交付路径,都能尽在掌握。

洞察阿里云部署的全球连接情况

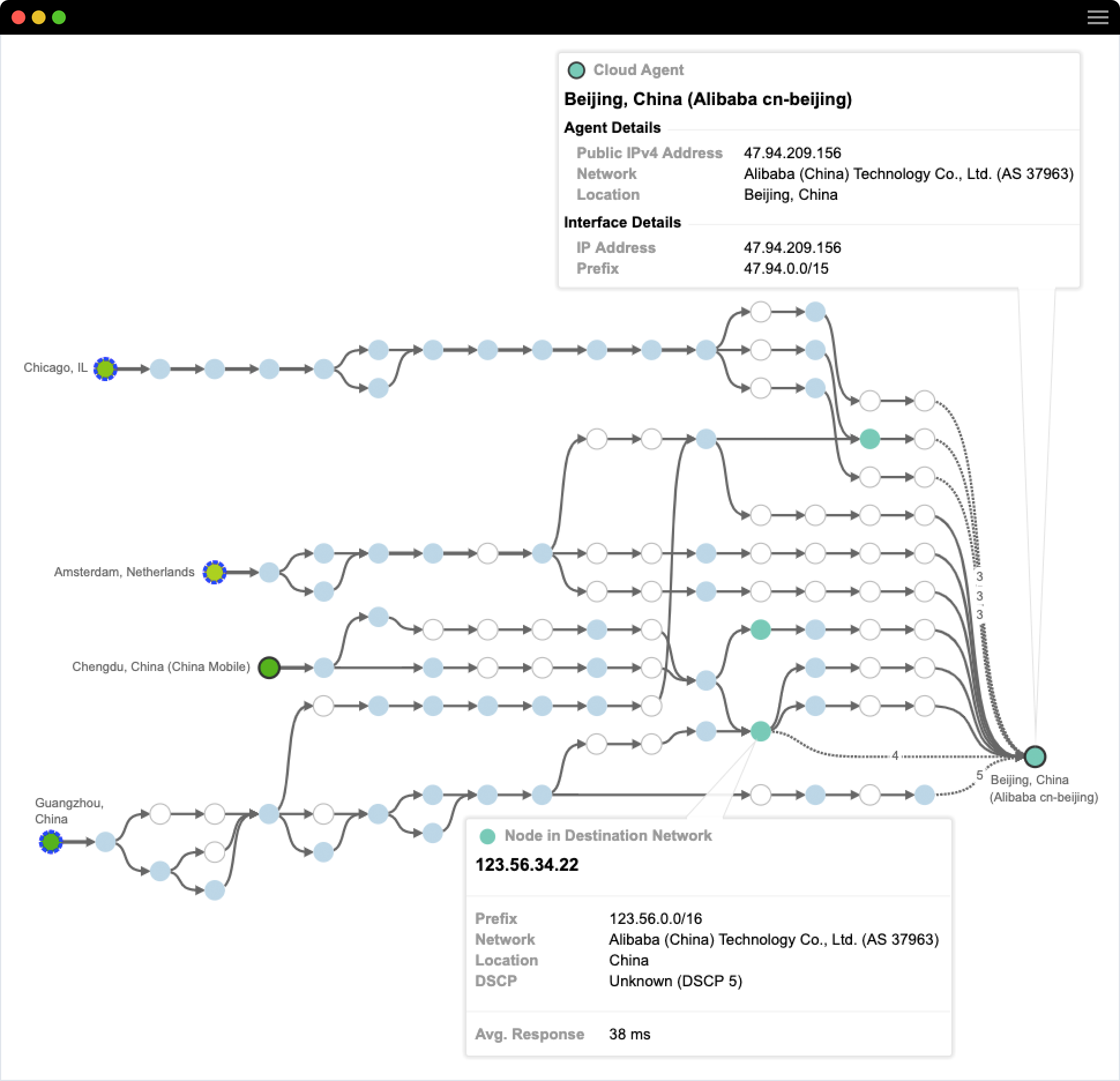

借助 ThousandEyes Cloud Agent, 您可以获得针对阿里云部署的实时可视性。我们已在 271 多个城市(包括 19 个阿里云区域)实现了 Cloud Agent 的部署支持。此外,您也可以将 ThousandEyes 的轻量级 Enterprise Agent 作为 ECS 实例部署到您的虚拟私有云 (VPC),通过它监控区域服务依赖关系,排除混合架构问题,并实现双向网络路径可视化。只需结合使用这两种观测点,您就能获得前所未有的端到端路径可视性,全面洞察企业局域网、广域网、ISP 和阿里云服务。

云端争霸:AWS、Azure、GCP、IBM 和阿里云测评比较

ThousandEyes 产品营销总监 Archana Kesavan 发布了第二届年度云性能基准测评结果。目前,这是业内唯一能够获得的关于主要云服务的数据驱动测评结果,涵盖了 AWS、Azure、GCP,以及今年新增的 IBM 和阿里云。

为什么选择 ThousandEyes?

更快上云

遍布云提供商区域的 Cloud Agent 可收集 Web 服务应用的关键指标,帮助即时洞察云网络和云应用的性能。

打造卓越的数字体验

揭示隐藏的依赖关系,并从云基础设施获取有关外部服务(如 API 网关)的直观情报。

简化 IT 运维

与内部和外部利益相关方共享控制面板监控数据、指标和可视化信息,从而加强协作,厘清责任,并通过确定根本原因加快问题解决。

精选博客文章

云性能报告中的主要见解

对您而言,扩展本土云的可视性意味着什么?

立即体验阿里云网络监控